- Ubuntu 58

- GNU/Linux 45

- Software 33

- debian 32

- linux 14

- programming 12

- Recursos 10

- Scripts 10

- Anuncios 9

- General 9

- Python 9

- Local 8

- Programación 8

- Perl 7

- Seguridad 7

- elixir 7

- software+libre 7

- CSS 6

- Charlas 6

- django 6

- Noticias 5

- WordPress 5

- planet 5

- trac 5

- (X)HTML 4

- Distribuciones 4

- GIMP 4

- Universidad 4

- javascript 4

- miniblog 4

- subversion 4

- ula 4

- Ingeniería del Software 3

- Internet 3

- Literatura 3

- Ocio 3

- campaign 3

- dapper 3

- planetalinux 3

- security 3

- wireless 3

- apache 2

- bittorrent 2

- blogging 2

- bug 2

- cnti 2

- cpan 2

- feedjack 2

- gnome 2

- gnu 2

- java 2

- jquery 2

- layout 2

- pylint 2

- tips 2

- xmms 2

- Duke 1

- Enlightenment 1

- Humor 1

- Kubuntu 1

- Opinión 1

- Personal 1

- akismet 1

- alsa 1

- amigas 1

- apt-get 1

- audioconverter 1

- azureus 1

- bad-behavior 1

- beamer 1

- beryl 1

- blog 1

- bluefish 1

- books 1

- browser 1

- canaima 1

- charla 1

- chile 1

- cms 1

- cntlm 1

- conac 1

- conocimiento+libre 1

- cowbell 1

- cracklib 1

- csv 1

- cultura 1

- dbconfig-common 1

- debconf 1

- dell 1

- design 1

- dictionary 1

- dijkstra 1

- documental 1

- drake 1

- edubuntu 1

- emerald 1

- entities 1

- etch 1

- fedora 1

- feed 1

- femfox 1

- find 1

- firefox 1

- flickr 1

- flisol 1

- foro 1

- framework 1

- freeloader 1

- gedit 1

- glamour 1

- gnickr 1

- gnupg 1

- goobuntu 1

- google 1

- google+evil 1

- graph 1

- graphviz 1

- grub 1

- grunt 1

- gulmer 1

- hardware 1

- html 1

- hwinfo 1

- icons 1

- ifdown 1

- ifup 1

- inkscape 1

- instalinux 1

- intel 1

- ipw3945 1

- iso 1

- iwl3945 1

- jigdo 1

- jsdoc 1

- k2 1

- kernel 1

- latex 1

- lenovo 1

- logitech 1

- lug 1

- m1210 1

- magazine 1

- marketing 1

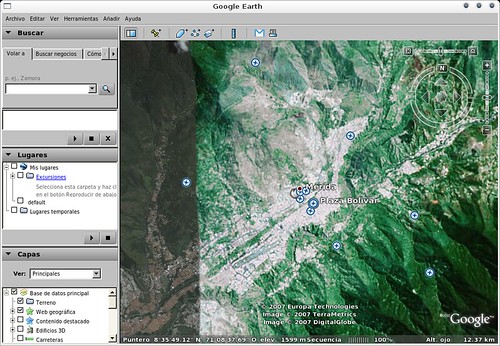

- merida 1

- mkpasswd 1

- mongodb 1

- mp3 1

- mp3splt 1

- mp3wrap 1

- mplayer 1

- music 1

- nautilus 1

- ndiswrapper 1

- network-manager 1

- nvidia 1

- pam 1

- pbuilder 1

- perl 1

- postgresql 1

- presentaciones 1

- proxy 1

- python 1

- root 1

- rss 1

- rufus 1

- scm 1

- scripting 1

- solve 1

- spam 1

- spam-karma 1

- stardict 1

- suse 1

- sysadmin 1

- tecnologia 1

- tecnologia+libre 1

- testing 1

- transmission 1

- trucos 1

- turpial 1

- ubuntuchannel 1

- ulanix 1

- utw 1

- velug 1

- venezuela 1

- video 1

- vim 1

- vlc 1

Ubuntu

Configurando nuestras interfaces de red con ifupdown

Si usted es de esas personas que suele mover su máquina portátil entre varias redes que no necesariamente proveen DHCP y usualmente vuelve a configurar sus preferencias de conexión, seguramente este artículo llame su atención puesto que se explicará acerca de la configuración de diversos perfiles de conexión vía línea de comandos.

En los sistemas Debian y los basados en él, Ubuntu por ejemplo, para lograr la configuración de las redes existe una herramienta de alto nivel que consiste en los comandos ifup e ifdown, adicionalmente se cuenta con el fichero de configuración /etc/network/interfaces. También el paquete wireless-tools incluye un script en /etc/network/if-pre-up.d/wireless-tools que hace posible preparar el hardware de la interfaz inalámbrica antes de darla de alta, dicha configuración se hace a través del comando iwconfig.

Para hacer uso de las ventajas que nos ofrece la herramienta de alto nivel ifupdown, en primer lugar debemos editar el fichero /etc/network/interfaces y establecer nuestros perfiles de la siguiente manera:

auto lo

iface lo inet loopback

# Conexión en casa usando WPA

iface home inet dhcp

wpa-driver wext

wpa-ssid foo

wpa-psk baz

wpa-keymgmt WPA-PSK

wpa-pairwise TKIP CCMP

wpa-group TKIP CCMP

wpa-proto WPA RSN

# Conexión en la oficina

# sin DHCP

iface office inet static

wireless-essid bar

wireless-key s:egg

address 192.168.1.97

netmask 255.255.255.0

broadcast 192.168.1.255

gateway 192.168.1.1

dns-search company.com #[email protected]

dns-nameservers 192.168.1.2 192.168.1.3 #[email protected]

# Conexión en reuniones

iface meeting inet dhcp

wireless-essid ham

wireless-key s:jam

En este ejemplo se encuentran 3 configuraciones particulares (home, work y meeting), la primera de ellas define que nos vamos a conectar con un Access Point cuyo ssid es foo con un tipo de cifrado WPA-PSK/WPA2-PSK, esto fue explicado en detalle en el artículo Haciendo el cambio de ipw3945 a iwl3945. La segunda configuración indica que nos vamos a conectar a un Access Point con una IP estática y configuramos los parámetros search y nameserver del fichero /etc/resolv.conf (para más detalle lea la documentación del paquete resolvconf). Finalmente se define una configuración similar a la anterior, pero en este caso haciendo uso de DHCP.

Llegados a este punto es importante aclarar lo que ifupdown considera una interfaz lógica y una interfaz física. La interfaz lógica es un valor que puede ser asignado a los parámetros de una interfaz física, en nuestro caso home, office, meeting. Mientras que la interfaz física es lo que propiamente conocemos como la interfaz, en otras palabras, lo que regularmente el kernel reconoce como eth0, wlan0, ath0, ppp0, entre otros.

Como puede verse en el ejemplo previo las definiciones adyacentes a iface hacen referencia a interfaces lógicas, no a interfaces físicas.

Ahora bien, para dar de alta la interfaz física wlan0 haciendo uso de la interfaz lógica home, como superusuario puede hacer lo siguiente:

# ifup wlan0=home

Si usted ahora necesita reconfigurar la interfaz física wlan0, pero en este caso particular haciendo uso de la interfaz lógica work, primero debe dar de baja la interfaz física wlan0 de la siguiente manera:

# ifdown wlan0

Seguidamente deberá ejecutar el siguiente comando:

# ifup wlan0=work

Es importante hacer notar que tal como está definido ahora el fichero /etc/network/interfaces ya no es posible dar de alta la interfaz física wlan0 ejecutando solamente lo siguiente:

ifup wlan0

La razón de este comportamiento es que el comando ifup utiliza el nombre de la interfaz física como el nombre de la interfaz lógica por omisión y evidentemente ahora no está definido en el ejemplo un nombre de interfaz lógica igual a wlan0.

En un próximo artículo se harán mejoras en la definición del fichero /etc/network/interfaces y su respectiva integración con una herramienta para la detección de redes que tome como entrada una lista de perfiles de redes candidatas, cada una de ellas incluyendo casos de pruebas. Teniendo esto como entrada ya no será necesario indicar la interfaz lógica a la que se hace referencia ya que la herramienta se encargará de probar todos los perfiles en paralelo y elegirá aquella que cumpla en primera instancia con los casos de prueba. De modo tal que ya podremos dar de alta nuestra interfaz física con solo hacer ifup wlan0.

Configurando el sonido (HDA Intel) en Lenovo 3000 c200 en Debian GNU/Linux

La situación poco común se presentó con un portátil Lenovo, específicamente un 3000 c200; el computador en cuestión mostraba la tarjeta funcionando, como si estuviera todo normal, pero sucede que no había sonido en lo absoluto por más altos que estuvieran los indicadores gráficos del volumen. Indagando por Google me encontré que ya han habido muchos casos similares, no solamente para laptops Lenovo, sino para la mayoría que incluye ese tipo de tarjetas y me encontré con una solución en un foro que me funcionó perfecto. Acá voy a tratar de explicar paso a paso todo lo que hice para que funcionara como debe ser.

Lo primero que se hizo fué asegurarse que se trata realmente de una tarjeta HDA Intel, con la siguiente línea de comandos:

$ lspci | grep High

…a lo que se obtuvo la siguiente respuesta:

00:1b.0 Audio device: Intel Corporation 82801G (ICH7 Family) High Definition Audio Controller (rev 02)

…donde se puede verificar que se trata de la HDA de la familia ICH7 de la Intel. Una vez verificado ésto, se procede a instalar algunos paquetes necesarios para que todo funcione de manera correcta, que son los siguientes:

- build-essentials

- gettext

- libncurses5-dev

Ésto se logró con el aptitude, con la siguiente línea de comandos:

$ sudo aptitude install el_paquete_que_quiero_instalar

Luego hay que descargar las cabeceras del kernel que se está usando. Para ésto, la manera más fácil de hacerlo fué instalando el paquete module-assistant y haciendo lo siguiente en una terminal:

$ sudo m-a update

$ sudo m-a prepare

Y el programa automáticamente va a saber cuáles cabeceras descargar y el directorio donde ponerlas. Cuando estén instalados éstos tres paquetes también se va a necesitar descargar de la página del Proyecto Alsa tres archivos necesarios y que son nombrados a continuación:

Se pueden descargar con un gestor de descargas preferido, ésto se hizo con wget, utilizando la línea de comandos:

$ wget -c http://www.alsa-project.org/alsa-driver-1.0.14.tar.bz2

…y así para cada uno de los archivos. Cuando se tengan los tres archivos, se copian a la carpeta /usr/src/alsa/ la cual, probablemente no existe todavía en el sistema y por lo tanto tendrá que ser creada; ésto se puede lograr con la siguiente línea de comandos:

$ sudo mkdir /usr/src/alsa

…cuando se tenga el directorio, se copian los tres archivos tar.gz al mismo; ésto se puede lograr con:

$ sudo cp alsa* /usr/src/alsa/

Luego hay que descomprimir los ficheros tar.gz con:

$ sudo tar xvf el_archivo_que_vamos_a_descomprimir.tar.gz

Una vez descomprimidos nos ubicamos en la primera carpeta que va a ser alsa-driver-1.0.14/ y compilamos el alsa para las tarjetas HDA Intel con las siguientes líneas de comandos:

$ sudo ./configure --with-cards=hda-intel

$ sudo make

$ sudo make install

Luego vamos a necesitar compilar los otros 2 paquetes restantes, para ello, nos ubicamos en la carpeta correspondiente y hacemos en una terminal lo siguiente:

$ sudo ./configure

$ sudo make

$ sudo make install

Ésto se va a hacer tanto para alsa-lib como para alsa-utils, pues el procedimiento es el mismo. Cuando se hayan compilado los tres paquetes el sistema ya debería ser capaz de reconocer correctamente la tarjeta y por lo tanto debe haber sonido; Ésto puedes ser verificado (1) Abriendo un reproductor de preferencia y reproduciendo algo de musica ó (2) Se puede hacer con la siguiente línea:

$ cat /dev/urandom >> /dev/dsp/

Con lo cual se obtendrá un sonido algo parecido a unos aplausos, pero en realidad son sonidos producidos aleatoriamente.

Ésto debería ser todo. En las máquinas que se configuraron, cuando se conectaban los audífonos en el panel lateral, el sonido salía tanto por los audífonos como por las cornetas y al parecer se solucionó con una reiniciada, pero sino quieres reiniciar entonces lo que tienes que hacer es tumbar los módulos que se crearon y volverlos a cargar, tal cual reiniciaras el sistema:

$ sudo modprobe -r snd_hda_intel652145

$ sudo modprobe -r snd_pcm

$ sudo modprobe -r snd_page_alloc

Luego para cargarlos hacemos las mismas línea, pero sin la opción -r.

Transmission 0.72 en Debian y Ubuntu GNU/Linux AMD64

Bien, en realidad, no he podido esperar a tenerlo trabajando al 100%, se trata de la versión 0.72 de Transmission, el que a mi parecer, es el mejor cliente BitTorrent que jamás haya existido. Según lo describen en la página, cito textualmente:

Transmission has been built from the ground up to be a lightweight, yet powerful BitTorrent client. Its simple, intuitive interface is designed to integrate tightly with whatever computing environment you choose to use. Transmission strikes a balance between providing useful functionality without feature bloat. Furthermore, it is free for anyone to use or modify.

Su instalación es muy fácil, ya que lo único que tenemos que hacer, es bajarnos el .deb (sí, el .deb, imagínense lo fácil que nos va a resultar) de la página de nuestros amígos de GetDeb y luego usar una terminal ó el instalador de paquetes GDebi (aún más fácil) para instalar el paquete.

En el primer de los casos, usando la terminal, lo único que tenemos que hacer en escribir la siguiente línea de comandos:

$ sudo dpkg -i transmission_0.72-0~getdeb1_amd64.deb

`` …esperar a que termine el proceso de instalación y ya podrás ejecutar el Transmission desde Aplicaciones –> Internet –> Transmission.

Para el segundo de los casos, usando el instalador GDebi, tan sólo hay que hacer click encima del .deb con el botón derecho del ratón y seleccionamos la opción Abrir con “Instalador de paquetes GDebi” y luego click en el botón Instalar el paquete, finalmente esperar a que finalice la instalación del paquete y listo!. Una de las cosas que, debo admitir, más me gusta de ésta nueva versión, es que ahora podemos minimizar la aplicación en la bandeja del sistema :) .

Para más información de Transmission, visite su Página Oficial.

StarDict: El diccionario que buscaba

Leyendo el ejemplar #14 de la revista Tux Magazine me encuentro con un interesante artículo, Learning Foreign Languages with jVLT and StarDict, la segunda aplicación descrita en dicho artículo, StartDict, llamó mi atención, así que a continuación se dará una breve revisión de la aplicación en cuestión.

¿Qué es StarDict?

StarDict es un diccionario internacional multiplataforma escrito en Gtk2, puede ser utilizado sin conexión a la web.

Características

-

Búsqueda de patrones: Usted puede buscar patrones de cadenas o caracteres usando comodines, por ejemplo, podrá usar el comodín

*para buscar una cadena arbitraria, el resultado puede ser vacío, mientras que con el uso del comodín?buscará una coincidencia con un carácter arbitrario. e.g. Suponiendo que tiene instalado el diccionario Inglés – Español, al buscar el patrón hell? encontrará como resultado la traducción de hello, mientras que con el uso del patrón hell* encontrará todas aquellas posibles coincidencias que comiencen con la cadena hell, hell (infierno en inglés), hell (suerte en noruego), los resultados encontrados dependerá de los diccionarios que haya instalado. - Búsqueda difusa: Si usted por casualidad no recuerda exactamente como deletrear una palabra, podrá intentar realizar dicha búsqueda desde StarDict, éste utilizará el algoritmo de la Distancia de Levenshtein El algoritmo de la Distancia de Levenshtein o la distancia de edición entre dos cadenas, se refiere al número mínimo de operaciones necesarias para transformar una cadena en otra, bajo éste algoritmo se considera una operación a la inserción, eliminación o substitución de un carácter. Para mayor información le recomiendo leer el artículo Levenshtein Distance, in Three Flavors.. Para utilizar esta característica simplemente comience la búsqueda con el carácter /, e.g., suponga que tiene instalado el diccionario Español – Inglés, usted cree que la palabra acero realmente se escribe así: asero, simplemente introduzca en el formulario la cadena /asero, obtendrá el resultado deseado.

-

Búsqueda por palabras seleccionadas:

Si usted desea activar esta característica, deberá marcar la casilla de verificación que se encuentra en la parte inferior izquierda de la ventana principal de la aplicación. StarDict automáticamente buscará palabras o frases que usted haya seleccionado en cualquier aplicación, esto incluye navegadores, OpenOffice.org, etc., usted obtendrá un cuadro de dialogo que le mostrará la definición acerca de la palabra seleccionada.

Si usted desea activar esta característica, deberá marcar la casilla de verificación que se encuentra en la parte inferior izquierda de la ventana principal de la aplicación. StarDict automáticamente buscará palabras o frases que usted haya seleccionado en cualquier aplicación, esto incluye navegadores, OpenOffice.org, etc., usted obtendrá un cuadro de dialogo que le mostrará la definición acerca de la palabra seleccionada. -

Manejo de diccionarios:

StarDict le permite activar (desactivar) aquellos diccionarios que necesite (no necesite), también puede establecer el orden de búsqueda en los distintos diccionarios instalados. Todo lo anterior podrá realizarlo desde la sección Manage Dictionaries (Recurso: Imagen).

StarDict le permite activar (desactivar) aquellos diccionarios que necesite (no necesite), también puede establecer el orden de búsqueda en los distintos diccionarios instalados. Todo lo anterior podrá realizarlo desde la sección Manage Dictionaries (Recurso: Imagen). - ¿No encuentra lo que necesita?: StarDict le permite realizar búsquedas en la web, solo deberá seleccionar el botón de búsqueda en Internet y escoger cualquiera de las 10 opciones actuales de búsqueda.

Ahora bien, seguramente esta aplicación resultará útil para muchas personas, si usted es uno de ellos y está interesado en instalarlo, es muy sencillo.

¿Cómo instalar StarDict?

Si usted es tan afortunado como yo, debe estar usando Debian, así que simplemente tendrá que hacer:

# aptitude install stardict

Ahora bien, si usted utiliza por ejemplo, Ubuntu, también puede instalarlo fácilmente, ¿cómo?, en primer lugar debe activar el repositorio universe (recuerde actualizar la lista de paquetes disponibles), posteriormente debe hacer:

$ sudo aptitude install stardict

Si usted utiliza otra distribución de GNU+Linux o es usuario de Windows, lea la documentación de la página oficial del proyecto, lamento informarle que este artículo es una revisión breve de la aplicación StarDict.

¿Cómo instalar diccionarios?

Primero que nada, debe descargar los diccionarios que necesite, para ello le recomiendo ir a la página de Descarga de Diccionarios del proyecto.

Una vez que haya descargado los diccionarios, debe proceder como sigue:

tar -C /usr/share/stardict/dic -x -v -j -f \\

diccionario.tar.bz2

Personalizando la aplicación

Ya para finalizar, usted puede personalizar la aplicación desde la sección de preferencias, desde ella podrá modificar el comportamiento del programa.

Ya para finalizar, usted puede personalizar la aplicación desde la sección de preferencias, desde ella podrá modificar el comportamiento del programa.

Una característica de StarDict que puede resultar realmente molesta es cuando se encuentra activo el modo Scan, es decir, toda palabra o frase resaltada con el ratón generará un cuadro de dialogo con la definición de dicha palabra o frase, si usted desea controlar este comportamiento, le recomiendo activar las siguientes casillas de verificación:

- Only do scanning while modifier key being pressed.

- Hide floating window when modifier key pressed.

Las casillas de verificación previamente mencionadas podrá encontrarlas bajo la sección Dictionary -> Scan Selection.

Si usted esta inconforme con las opciones de búsqueda en Internet, puede agregar las que usted desea desde la sección Main Window -> Search Website.

Actualizado Planeta #ubuntu-es

El hecho de haber dejado de utilizar ubuntu, como lo he manifestado en entradas anteriores, no implica que deba dejar de lado a los amigos del canal #ubuntu-es en el servidor Freenode, además, tampoco debo dejar de cumplir mis deberes de administrador del Planeta #ubuntu-es, por ello, he realizado los siguientes cambios:

- Se actualiza WordPress a su versión 2.0.2.

- Se actualiza el plugin FeedWordPress, basicamente este plugin es un agregador de contenidos Atom/RSS.

- Ahora el dominio principal del Planeta #ubuntu-es es http://www.ubuntuchannel.org/, aunque se han establecido reglas de redirección en el fichero .htaccess para hacer el cambio lo menos traumático posible.

Aún faltan muchos detalles, en este preciso instante no puedo resolverlos debido a un viaje que debo realizar fuera del estado dentro de una hora, el lunes cuando regrese a casa continuare la labor, mientras tanto, le agradezco que si percibe algún error en el nuevo sitio o tiene alguna sugerencia en particular, por favor deje un comentario en esta entrada.

Para quienes deseen suscribirse al Planeta #ubuntu-es, el URI del feed ha cambiado a http://www.ubuntuchannel.org/feed/. Para aquellas personas que estaban suscritas, este cambio no debería afectarles, puesto que se han establecido reglas de redirección.

Si deseas ser miembro, por favor envia un mensaje a través de la sección de contacto del Planeta #ubuntu-es.

Creando listas de reproducción para XMMS y MPlayer

Normalmente acostumbro a respaldar toda la información que pueda en medios de almacenamiento ópticos, sobretodo audio digital, ya sea en ficheros Ogg Vorbis o en MPEG 1 Layer 3. Desde hace poco más de un año hasta la actualidad me he acostumbrado a mantener una estructura lógica, la cual es más o menos como sigue:

/music/

Pero hace mucho tiempo no era tan organizado en cuanto a la estructura de los respaldos, entonces, la pregunta en cuestión es, ¿cómo lograr detectar la presencia de ficheros de audio digital almacenados de manera persistente en un dispositivo óptico de manera automática?

Al igual que lo expresado en la entrada Eliminando ficheros inútiles de manera

recursiva,

haremos uso del comando find.

Antes de entrar en detalle debo aclarar que voy a realizar una búsqueda recursiva de ficheros en el path correspondiente a mi unidad lectora de CDs. Usted debe ajustar el path por uno apropiado en su caso particular.

Si solo desea buscar ficheros MPEG 1 Layer 3:

find /media/cdrom1/ -name \*.mp3 -fprint playlist

Pero si usted acostumbra a almacenar ficheros Ogg Vorbis en conjunto con ficheros MPEG 1 Layer 3, debería proceder así:

find /media/cdrom1/ \( -name \*.mp3 -or -name \*.ogg \) -fprint playlist

El comando anterior también es aplicable para generar listas de reproducción de video digital, en cuyo caso lo único que debe cambiar es la extensión de los ficheros que desea buscar. El fichero que contendrá la lista de reproducción generada en los casos expuestos previamente será playlist.

Reproduciendo la lista generada

Para hacerlo desde XMMS es realmente sencillo, acá una muestra:

xmms --play playlist --toggle-shuffle=on

Si usted no desea que las pistas en la lista de reproducción se reproduzcan

de manera aleatoria, cambie el argumento on de la opción

--toggle-shuffle por off, quedando como --toggle-shuffle=off.

Si desea hacerlo desde MPlayer es aún más sencillo:

mplayer --playlist playlist -shuffle

De nuevo, si no desea reproducir de manera aleatoria las pistas que se

encuentran en la lista de reproducción, elimine la opción del reproductor

MPlayer -shuffle del comando anterior.

Si usted desea suprimir la cantidad de información que le ofrece MPlayer al

reproducir una pista le recomiendo utilizar alguna de las opciones -quiet o

-really-quiet.

Ubuntu Dapper Drake Flight 6

Flight 6, es la última versión alpha disponible de Ubuntu Dapper Drake, esta versión ha sido probada razonablemente, pero recuerde que a pesar de ello todavía es una versión alpha, así que no se recomienda su uso en medios en producción. Esta versión puede descargarla desde:

- Europa:

- Reino unido y el resto del mundo:

- Bittorent: Se recomienda su uso si es posible.

- Sitios Espejos: Una lista de sitios espejos puede encontrarse en: Ubuntu Mirror System.

Una lista con los cambios notables en esta sexta versión alpha pueden ser encontrados en Dapper Flight 6.

Breve reseña del FLISOL 2006, Capítulo Mérida-Venezuela

Al llegar a eso de las 9:30 a.m. (hora local) estaban transmitiendo el video Trusted Computing (subtítulos español), un excelente video en donde nos muestran cuan peligroso puede ser la “mala interpretación” que tiene la industria acerca del concepto “Trusted Computing”, modelo en el cual la industria no le permite a los usuarios (comunidad) elegir entre lo que ellos consideran malo o nó, el problema es que ya deciden por tí, simplemente porque la industria no confía en nosotros.

Después de mostrar el video, Hector Colina, uno de los coordinadores del evento, procedió a dar la bienvenida a los asistentes al II Festival Latinoamericano de Instalación de Software Libre, capítulo Mérida, Venezuela. De inmediato, Hector continúo hablando y nos sorprendió con una charla denominada Software Libre y Libre Empresa, en donde nos hablaba de la interesante filosofía detrás del modelo de Software Libre, algunos piensan equivocadamente que bajo el esquema de Software Libre no se es posible generar ganancias, se demostró que es posible hacerlo. También hablo sobre las ventajas técnicas que brinda el Software Libre frente al Software Privativo.

Posteriormente se dió comienzo a las demostraciones de LTSP (Linux Terminal Server Project) por parte de José David Gutierrez, quien también coordinó el evento y es miembro de la Cooperativa AndiNuX, no recuerdo en este instante cuales eran las características que poseía el servidor, pero recuerdo que el cliente sobre el cual se hizo la demostración tenía apenas 40 MB de RAM (sí, leyo bien, 40 MB) y se logró levantar el entorno de escritorio KDE y ejecutar algunas aplicaciones, José comentaba que los requisitos mínimos de memoria RAM eran 16, mientras que lo óptimo erán 32 MB de RAM, así que amigo, si usted esta leyendo esto, no bote su potecito (equipo de bajo recursos de hardware), bajo el esquema de Software Libre podemos recuperarlo, quizá podría donarlo y regalarle una sonrisa a un niño que reciba educación en una escuela con pocos recursos.

Posteriormente comenzaron a colocar algunos videos a los asistentes, entre los cuales recuerdo haber visto Revolution OS, en paralelo, se realizaba el proceso de instalación desde tempranas horas de la mañana, al final de la jornada se lograron contabilizar más de 20 máquinas a las cuales se instaló GNU/Linux, incluyendo potecitos de 32 MB de RAM hasta máquinas de escritorio con procesadores de 64 bits, por supuesto, a una que otra portátil también se le instaló GNU/Linux, además, se regalaron CDs de Debian, Ubuntu, entre otros.

En la tarde el profesor Francisco Palm comenzó su charla Carpintería del Software Libre: un enfoque desde el lenguaje de Programación Python, en ella se nos hace reflexionar acerca de nuestra realidad actual en Venezuela, presentamos poca penetración de internet en nuestra sociedad. Bajo el esquema de Software Privativo, no se le brinda apoyo a la comunidad, no se presenta una innovación alguna.

El profesor Palm también converso sobre puntos interesantes acerca de la Ingeniería de Software Libre, como la Fundación Apache, Debian o Mozilla no presentan certificaciones y no les importa éste hecho en particular, puesto que su desarrollo es robusto, de hecho, muestran como funcionan por dentro. Entre otras cosas bastante interesantes.

Enseguida comenzaron otra charla 2 pupilos del profesor Palm, Diego Díaz y Freddy López, en donde se expuso el Proyecto SIGMA: Soluciones Libres para el mundo Científico, en esta charla pudimos observar una serie de demostraciones del sistema estadistico R. El proyecto SIGMA resulta de una iniciativa de los miembros de la Escuela de Estadística y el Instituto de Estadística Aplicada y Computación (IEAC) de la Universidad de Los Andes.

Sin mucho receso, Leonardo Caballero comenzó su charla acerca de Desarrollo Web con Mozilla FireFox, aca se explicó acerca de las extensiones que resultan muy útiles al desarrollador de páginas web, como por ejemplo, la extensión Web Developer, de manera adicional, se demostró cuan personalizable (desde utilizar temas hasta incluso simular comportarse como otro navegador) puede ser Firefox para un usuario particular, desde extensiones para el clima (ForecastFox) hasta herramientas de blogging.

Particularmente, para el desarrollo web utilizo más extensiones de las que mencionó Leonardo, entre ellas puedo mencionar: CSS Validator, ColorZilla, entre otras. Prefiero no continuar mencionando la lista de extensiones que poseo, se supone que sea una breve reseña, quizá en otro artículo hablaremos acerca de las extensiones de Firefox.

Un poco más tarde, el licenciado Axel Pizzi, quien pertenece a la agencia de traducción y servicios lingüisticos translinguas, conversó acerca del uso de herramientas CAT (Computer aided Translation) bajo el esquema de Software Libre, simplemente se mostraba las bondades de la traducción asistida por computadora, es una manera de traducir contenido en donde el ser humano (traductor) utiliza software diseñado para brindar soporte y facilitar ésta ardua tarea.

Algo nervioso se encontraba Jesús Rivero (no confundir con neurogeek, ok?), pues se estaba haciendo tarde para su charla, Cooperativismo y Software Libre, en donde Jesús mostró como el esquema de desarrollo colaborativo es sumamente útil en las Cooperativas.

Y ya para finalizar la jornada, comence mi charla sobre Desarrolo Web en Python utilizando el framework Django, a manera de introducción, comence a hablar del lenguaje de programación Python, sus bondades, que empresas le utilizan actualmente y que proyectos han desarrollado, entre dicha lista se incluyen las siguientes: Google, Yahoo!, empresas farmacéuticas (AstraZeneca) de gran escala mundial, Industrial Light & Magic (sí, esa misma que está pensando, es la empresa iniciada por George Lucas en el año de 1.975, la encargada de los efectos especiales de la saga “Star Wars”, no solo eso, en su lista se incluyen películas como “Forrest Gump”, “Jurassic Park”, “Terminator 2”, entre otros).

Posteriormente comence a adentrarme ya en el tema que me interesaba, Desarrollo Web, en mi caso particular, hable sobre como utilizar el framework Django, desde la instalación del framework, la instalación de PostgreSQL (recomendada) y del adaptador a dicha base de datos en python, psycopg, hasta la construcción de la aplicación. Para mayor detalle acerca de esta presentación solo esperen un próxima entrada, quisiera ampliar algunos tópicos para dejarlos un poco más claros.

Si desean ver algunas fotos que logré tomar del II Festival Latinoamericano de Instalación de Software Libre (FLISOL), Capítulo Mérida - Venezuela, pueden revisar el set de fotos FLISOL 2006 de mi cuenta en flickr.

Debo confesar que estaba bastante nervioso al principio porque era mi primera charla. Espero que todo haya salido bien y les haya gustado.

Bueno, finalizamos las actividades como a las 7:30 p.m. (hora local), luego de ello ayudamos a los muchachos a acomodar las cosas y guardarlas en las oficinas de Fundacite Mérida.

Desde mi punto de vista, ha sido una grata experiencia, cualquier corrección a la reseña es bienvenida, pido disculpas si he dejado a alguien por fuera, esta reseña no estaba anotada en ningún medio escrito, solo he comenzado a describir las situaciones que recuerdo, lo más seguro es que olvide algún detalle importante, andaba un poco distraído instalando Debian y Ubuntu en el Festival.

Por supuesto, cualquier corrección, crítica constructiva acerca de la charla que dí se los agradecería, todo sea por mejorar dicho material y publicarlo, por supuesto, manteniendo una licencia libre.

Libro oficial de Ubuntu

La primera edición del libro The Official Ubuntu Book estará lista para el día 4 de Agosto de este mismo año y contará con 320 páginas; la información anterior puede encontrarse en la preventa del libro realizada en Amazon.

Los autores del libro The Official Ubuntu Book son los siguientes:

- Benjamin Mako Hill: Autor del famoso libro Debian GNU/Linux 3.x Bible, desarrollador debian/ubuntu.

- Jono Bacon: Co-autor del libro Linux Desktop Hacks, publicado por O’Reilly, entre otras cosas, Jono colabora con el proyecto KDE.

- Corey Burger: Administrador del proyecto Ubuntu Documentation Project.

- Otros autores: Entre ellos se encuentran Ivan Krstic y Jonathan Jesse.

Este libro tendrá una licencia Creative Commons.

nVIDIA en Ubuntu 6.04

Hace unos días actualicé mi Ubuntu 5.10 a una de sus últimas versiones de testing: Flight 5. Debo admitir que quedé anonadado por lo cambios en la distribución, ya que con todas las mejoras que tiene parece que hubiera pasado, no sólo 6 meses sino años. El Dapper Drake (Flight 5, Ubuntu 6.04) es mucho mejor que sus antecesores. Pero la razón por la cual me decidí a escribir éste artículo es otra: la instalación de los drivers de mi tarjeta nVIDIA y su puesta en funcionamiento a punto.

Cuando actualicé mi sistema no hubo ningún problema, y lo digo en serio, ningún problema de ninguna índole. Toda mi configuración de escritorio quedó intacta; pero empecé a notar que la configuración de la tarjeta de video no se cargaba con el sistema. Entonces supe que, por alguna razón, los drivers de la tarjeta habían cambiado, es decir, el sistema asignó el driver por defecto para la tarjeta, más no los drivers de la tarjeta misma. Entonces tuve que ponerme a configurar la tarjeta.

Lo primero que hice fué verificar que los drivers vinieran con la distribución. Lo hice con la siguiente línea:

$ sudo aptitude search nvidia

Con lo cual obtuve lo siguiente:

i nvidia-glx - NVIDIA binary XFree86 4.x/X.Org driver

v nvidia-kernel-1.0.7174 -

v nvidia-kernel-1.0.8178 -

i nvidia-kernel-common - NVIDIA binary kernel module common files

Entonces ya sabía que los drivers venían con la distro, lo cual me pareció fascinante, ya que en realidad el Flight 5, no es la versión definitiva del Dapper Drake. Luego procedí a verificar la documentación de dicho paquete. Ésto lo hice con la siguiente línea de comandos:

$ sudo aptitude show nvidia-glx

Esto lo hice para verificar que no haya alguna clase de conflictos con otros paquetes, pero en realidad no es un paso necesario, ya que aptitude resuelve todo tipo de conflictos y dependencias. Después de verificar que todo estaba en orden me decidí a instalar los drivers. Ésto lo hice con la siguiente linea de comandos:

$ sudo aptitude install nvidia-glx

Con lo cual quedaron instalados los drivers de la tarjeta de manera trasparente y rápida. Lo siguiente que debía hacer, era activar la configuración de la tarjeta. Lo cual hice con la siguiente línea de comandos:

$ sudo nvidia-glx-config enable

Una vez hecho ésto ya podía configurar la tarjeta. Algo que hay que hacer notar es que, para las distribuciones anteriores de Ubuntu, había que instalar de manera separada el paquete nvidia-glx y el nvidia-settings, sin embargo, aquí queda todo instalado de una vez. Lo que sigue es iniciar la configuración de la tarjeta, lo cual hice con la siguiente línea de comandos:

$ nvidia-settings

Y ya tenía acceso a la configuración de mi tarjeta. Sin embargo, al hacer todo ésto, la configuración no se carga al iniciar el sistema, pero no fué problema, porque lo solucioné colocando en los programas de inicio del gnome-session-manager los siguiente:

nvidia-settings -l

Este comando carga la configuración de nvidia-settings que tengamos actualmente. Es lo mismo que, una vez que haya cargado el sistema, ejecutemos en la consola éste comando, sólo que ahora se va a ejecutar apenas inicie el sistema operativo.

Otros ajustes…

Si quieren colocar un lanzador en los menús del panel de gnome deben hacer los siguiente:

$ sudo gedit /usr/share/applications/NVIDIA-Settings.desktop

Y luego insertar lo siguiente en dicho fichero:

[Desktop Entry]

Name=Configuración nVIDIA

Comment=Abre la configuración de nVIDIA

Exec=nvidia-settings

Icon=(el icono que les guste)

Terminal=false

Type=Application

Categories=Application;System;

Y ya tendrán un lanzador en los menús del panel de gnome. Una opción sería utilizar el editor de menús Alacarte.

nvidia-xconf

nvidia-xconf es una utilidad diseñada para hacer fácil la edición de la configuración de X. Para ejecutarlo simplemente debemos escribir en nuestra consola lo siguiente:

$ sudo nvidia-xconfig

Pero en realidad, ¿qué hace nvidia-xconfig? nvidia-xconfig, encontrará el fichero de configuración de X y lo modificará para usar el driver nVIDIA X. Cada vez que se necesite reconfigurar el servidor X se puede ejecutar desde la terminal. Algo interesante es que cada vez que modifiquemos el fichero de configuración de X con nvidia-xconfig, éste hará una copia de respaldo del fichero y nos mostrará el nombre de dicha copia. Algo muy parecido a lo que sucede cada vez que hacemos:

dpkg-reconfigure xserver-xorg

Una opción muy útil de nvidia-xconfig es que podemos añadir resoluciones al fichero de configuración de X simplemente haciendo:

$ sudo nvidia-xconfig --mode=1280x1024

…por ejemplo.

Vulnerabilidad grave corregida en ubuntu

La vulnerabilidad en ubuntu donde cualquiera con acceso al shell podía ver la contraseña del instalador del sistema ha sido reparada.

Los paquetes afectados son base-config y passwd en Ubuntu 5.10 (Breezy Badger), el problema puede ser corregido al actualizar los paquetes afectados a las versiones 2.67ubuntu20 (base-config) y 1:4.0.3-37ubuntu8 (passwd). En general, una actualización del sistema es suficiente para que los cambios surtan efecto.

La vulnerabilidad en donde era posible ver la constraseña del instalador de ubuntu y así tener acceso a privilegios de superusuario (por supuesto, si la contraseña no había sido cambiada desde la instalación) fue descubierta por Karl Øie, el instalador de Ubuntu 5.10 falla en la limpieza de contraseñas en los ficheros de registros de instalación. Dichos ficheros pueden ser leidos por cualquiera, de este modo cualquier usuario local pudiese ver las contraseñas del primer usuario, el cual tiene privilegios por completo en una instalación por defecto.

El paquete actualizado eliminará las contraseñas almacenadas en texto plano en los ficheros de registro de instalación y adicionalmente hará que los registros sean leídos únicamente por el superusuario.

Esta vulnerabilidad no afecta a los instaladores de las versiones 4.10, 5.04, o la que está por llegar, 6.04. Sin embargo, considere necesario aplicar el parche si usted ha actualizado su sistema desde Ubuntu 5.10 a la actual versión en desarrollo 6.04 (Dapper Drake), en este caso verifique que ha actualizado el paquete passwd a la versión 1:4.0.13-7ubuntu2.

Más propuestas para la campaña en contra de la gestión del CNTI

David Moreno Garza (a.k.a. Damog) se ha unido a la campaña que apoya a la Asociación de Software Libre de Venezuela (SoLVe), la cual rechaza (al igual que nosotros) el acuerdo entre IBM Venezuela y el Centro Nacional de Tecnologías de Información (CNTI).

Damog nos sorprende con un script escrito en Perl que genera un botón personalizado con cierto mensaje.

Damog nos sorprende con un script escrito en Perl que genera un botón personalizado con cierto mensaje.

Para la puesta en funcionamiento del script necesitaremos en primera instancia instalar la variante gd2 del módulo en Perl que contiene a la librería libgd, ésta última librería nos permite manipular ficheros PNG.

Tanto en Debian como en su hijo Ubuntu el procedimiento es similar al siguiente:

$ sudo aptitude install libgd-gd2-perl

$ wget http://www.damog.net/files/misc/apoyo-solve-0.1.zip

$ unzip apoyo-solve-0.1.zip

$ cd apoyo-solve-0.1

$ perl apoyo-solve.perl <text>

En donde <text> debe ser reemplazado por su nombre o el de su sitio. Seguidamente proceda a subir la imagen.

Si lo desea, puede ver los diferentes banners de la campaña en contra de la gestión actual del CNTI, únase al llamado de la Asociación de Software Libre de Venezuela (SoLVe).

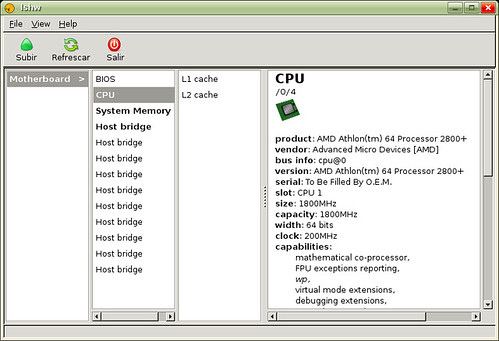

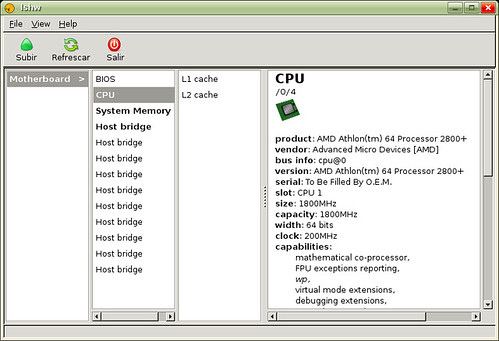

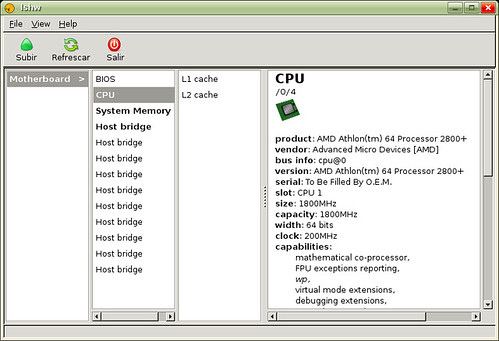

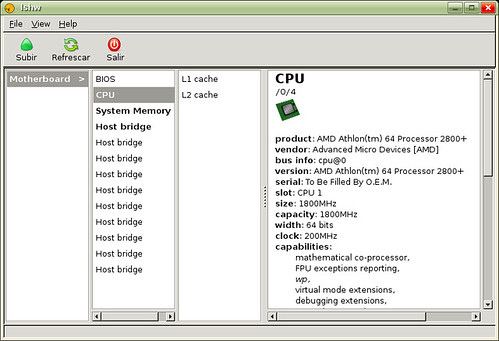

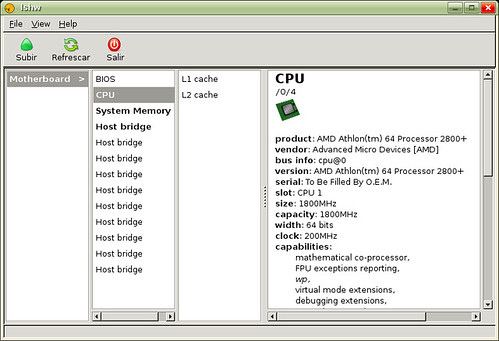

hwinfo: Detectando el hardware actual

hwinfo es un programa que nos permite conocer rápidamente el hardware detectado actualmente en nuestros ordenadores, por ejemplo, si deseamos obtener los datos de dispositivo SCSI, simplemente utilizamos el comando hwinfo --scsi.

Para instalar este programa en Ubuntu Linux en primer lugar debemos tener activados el repositorio universe, seguidamente haremos uso de aptitude, tal cual como sigue:

$ sudo aptitude install hwinfo

Si deseamos conocer el uso de este programa de manera detallada, simplemente escribimos hwinfo --help.

En el caso que haga uso del comando hwinfo sin parámetro alguno nos mostrará la lista completa del hardware detectado actualmente, es importante resaltar que esta lista puede ser muy extensa, por lo cual le recomiendo hacer uso de un pipe para administrar la salida generada por hwinfo y poder visualizarla página a página, tal cual como sigue.

$ hwinfo | less

Si por el contrario, usted solo desea conocer una lista resumida del hardware detectado haga uso del parámetro --short, lo anterior quedaría de la siguiente manera:

$ hwinfo --short

Este programa nos brinda bastantes opciones, es recomendable hacer uso de los parámetros cuando necesitamos información referente a un dispositivo en específico, por ejemplo, si deseamos conocer la información acerca de la tarjeta de sonido, hacemos lo siguiente:

$ hwinfo --sound

Como le mencione anteriormente, para conocer en detalle las opciones que nos brinda este programa, le recomiendo leer el manual. Espero sea de provecho ;)

Vulnerabilidad en el kernel Linux de ubuntu

Este problema de seguridad únicamente afecta a la distribución Ubuntu 5.10, Breezy Badger.

Los paquetes afectados son los siguientes:

linux-image-2.6.12-10-386linux-image-2.6.12-10-686linux-image-2.6.12-10-686-smplinux-image-2.6.12-10-amd64-genericlinux-image-2.6.12-10-amd64-k8linux-image-2.6.12-10-amd64-k8-smplinux-image-2.6.12-10-amd64-xeonlinux-image-2.6.12-10-iseries-smplinux-image-2.6.12-10-itaniumlinux-image-2.6.12-10-itanium-smplinux-image-2.6.12-10-k7linux-image-2.6.12-10-k7-smplinux-image-2.6.12-10-mckinleylinux-image-2.6.12-10-mckinley-smplinux-image-2.6.12-10-powerpclinux-image-2.6.12-10-powerpc-smplinux-image-2.6.12-10-powerpc64-smplinux-patch-ubuntu-2.6.12

El problema puede ser solucionado al actualizar los paquetes afectados a la versión 2.6.12-10.28. Posterior al proceso de actualización debe reiniciar el sistema para que los cambios logren surtir efecto.

Puede encontrar mayor detalle acerca de esta información en el anuncio Linux kernel vulnerability hecho por Martin Pitt a la lista de correos de avisos de seguridad en Ubuntu.

Goobuntu, Google y los rumores…

Todo comenzo el día martes de esta misma semana, al ser publicado el artículo Google at work on desktop Linux en The Register, para mí todo aquello tenía la esencia de un nuevo rumor acerca Google, no en el sentido de utilizar una adaptación, denominada Goobuntu, de Ubuntu para las personas que laboran dentro de Google, sino en el hecho que el artículo enfatizaba la posibilidad de distribuir al público en general la adaptación de Ubuntu hecha por Google.

En el artículo mencionado al comienzo del párrafo anterior nos encontramos con afirmaciones tales como las siguientes:

Google is preparing its own distribution of Linux for the desktop, in a possible bid to take on Microsoft in its core business - desktop software.

Un poco más tarde nos encontramos con esto.

But it’s possible Google plans to distribute it to the general public, as a free alternative to Windows.

La posible distribución de “Goobuntu” al público fue desmentida pocas horas después de publicada la noticia, el responsable de proyectos open source de Google, Chris DiBona, lo aclara en este comentario hecho en Slashdot [Vía], en donde afirma lo siguiente:

Goobuntu is our internal desktop distribution. It’s awesome, but we’re not going to be releasing it. Unless you work here it wouldn’t work anyway.

Una de las cosas que me impresionó de todo esto, fué lo rápido que se extendió esta noticia. Estaba por todos lados, en los blogs que comúnmente leo, en Technorati, bajo el tag ubuntu, solo se hablaba de ello. Más y más sitios se unían rápidamente a este grupo.

Me da la impresión que cada vez que termina un rumor acerca del probable Google OS o Google Browser comienza uno nuevo, ¿esto acabará algún día?, ¿es sano adorar tanto a Google?, acaso Google es tan cool que le hace olvidar a las personas los malos productos que ha sacado últimamente, pareciese que sí.

Siguiendo con el tema, llegados a este punto, ¿alguien recuerda el lanzamiento de Google Analytics?, este servicio de estadísticas gratis para sitios web desde el mismo día de su lanzamiento no dejó de dar problemas, fué un total desastre, ¿era muy difícil prever que este servicio iba a tener una demanda excesiva?, no lo creo, su rendimiento daba lastima, los servidores estaban saturados, páginas en mantenimiento después del lanzamiento, ¿acaso Google estaba jugando con nosotros?.

Supongo que Google ha olvidado esa parte de la mercadotecnia en donde se logra satisfacer las necesidades y requisitos de los consumidores, al fin y al cabo es una empresa que intenta responder a una economía de mercado, pero lo está haciendo mal.

Google ha demostrado su interes en el escritorio, aplicaciones como Google Desktop Search, Google Talk, Google Earth, Google Pack dan fé de ello. No puedo dar mi opinión acerca de estas últimas aplicaciones, puesto que no los he probado al ser solo para sistemas Windows, pero con los antecedentes que se está ganando últimamente Google, pareciese que no hace falta probarlos para sacar una conclusión de ellos. Sebastian Delmont puede aclarar un poco esta situación en el artículo El paquete de Google decepciona.

mp3wrap: Concatenando ficheros mp3

mp3wrap es una utilidad en línea de comando que nos permite fusionar o concatenar dos o más ficheros mp3, todo esto sin perder los nombres de ficheros y la información de los ID3, estándar que permite la inclusión de metadatos en contenedores multimedia. También es posible añadir otros ficheros que no sean mp3, como por ejemplo, listas de reproducción, ficheros de información, imágenes de portada. Claro, este proceso es posible revertirlo gracias a mp3splt, el cual describiré en un próximo artículo.

Con mp3wrap, usted puede fácilmente fusionar hasta un máximo de 255 ficheros en uno solo, lo cual pareciese ser suficiente para la mayoría. De igual manera, como se mencionó previamente, usted puede añadir ficheros que no sean mp3, pero hay algunas consideraciones al respecto.

- Si el fichero es de texto, como pueden ser las listas de reproducción, los ficheros de información, entre otros, se recomienda que estos se ubiquen al principio del fichero a generar, puesto que el reproductor los descartará rápidamente.

- Si el fichero es binario, como las imágenes por ejemplo, usted debe colocarlas al final del fichero a generar, de esta manera el reproductor se los encontrará después de reproducir y no los confundirá con ficheros

mp3.

Instalación del programa

Para poder instalar esta aplicación en Ubuntu, en primer lugar debemos tener activo en nuestro fichero /etc/apt/sources.list el repositorio universe, después de haber verificado esto procedemos a instalarlo.

$ sudo aptitude install mp3wrap

A continuación explicaré el uso de mp3wrap a través de un ejemplo.

En primer lugar, mostraré la lista de ficheros a fusionar.

$ ls

01.mp3 02.mp3 03.mp3 04.mp3

Ahora fusionaré las 2 primeras canciones.

$ mp3wrap album.mp3 01.mp3 02.mp3

He obviado el mensaje que nos muestra mp3wrap para evitar extender más de lo necesario este artículo. También es importante acotar que el fichero generado no se llamará album.mp3 (lo que pareciese lógico), sino album_MP3WRAP.mp3, es recomendable no borrar la cadena MP3WRAP, ésta le indicará al programa mp3splt, el cual nos permite separar de nuevo los ficheros fusionados, que dicho fichero fué fusionado utilizando mp3wrap, lo anterior nos facilitará su extracción con mp3splt, en caso de darse.

Ahora bien, voy a añadir las otras dos canciones, que conste que este paso lo hago solamente para demostrar como añadir otros ficheros a una compilación previamente hecha con mp3wrap.

$ mp3wrap -a album_MP3WRAP.mp3 03.mp3 04.mp3

Si deseamos conocer cuales son los archivos que contiene el fichero generado por mp3wrap, simplemente debemos hacer lo siguiente.

mp3wrap -l album_MP3WRAP.mp3

List of wrapped files in album_MP3WRAP.mp3:

01.mp3

02.mp3

03.mp3

04.mp3

Si en la instrucción anterior hubiesemos hecho uso de la opción -v (verbose), mp3wrap nos mostraría información adicional acerca de los ficheros. Por ejemplo:

mp3wrap -lv album_MP3WRAP.mp3

List of wrapped files in album_MP3WRAP.mp3:

# Size Name

--- -------- --------

1) 6724962 01.mp3

2) 9225205 02.mp3

--- -------- --------

15950240 2 files

Pueden observar en el ejemplo anterior que se nos muestra el tamaño en bytes de cada uno de los ficheros, así como el número total de ficheros que han sido fusionados y su tamaño correspondiente en bytes.

Como se ha podido ver a través del articulo el uso de mp3wrap es bastante sencillo, si tiene alguna duda acerca de su uso consulte el manual de mp3wrap, man mp3wrap, o la sección de preguntas mas frecuentes acerca de mp3wrap.

Instalinux: Instalando Linux de manera desatentida

Instalar GNU/Linux de manera desatendida ahora es realmente fácil haciendo uso de instalinux, esta interfaz web a través de unas preguntas acerca de como deseamos configurar nuestro sistema, nos permitirá crear una imagen que facilitará la instalación del sistema GNU/Linux de manera desatendida. Usted lo inserta, escribe install, y luego cuando regrese más tarde, tendrá un sistema GNU/Linux (la distribución de su escogencia) totalmente funcional esperando por usted.

Para todo lo descrito previamente, instalinux hace uso de scripts escritos en Perl que son parte del proyecto de código abierto LinuxCOE, desarrollado por Hewlett Packard.

Hasta ahora este servicio web gratuito permite crear métodos de instalación desatendida para las siguientes distribuciones:

- Fedora Core 4

- Debian

- SUSE

- Ubuntu

Instalinux nos permite seleccionar aquellos componentes que deseamos, posteriormente se crea una imagen de aproximadamente 30MB, la cual es clave para realizar la instalacion desatendida. Una vez culminado el proceso debemos descargar dicha imagen a nuestro disco duro.

Hasta ahora la propuesta que trae dicha interfaz gráfica me fascina, quizá el único punto débil que le veo es que posterior a la descarga de los aproximadamente 30MB usted deberá descargar los paquetes que solicite la instalación en su caso, esto último puede generar trauma en aquellas personas que no cuenten con conexiones de banda ancha.

Cowbell: Organiza tu música

Cowbell, es una aplicación que te permite organizar tus compilaciones musicales de una manera fácil y divertida, ya no tienes que aburrirte por horas al intentar organizar tus colección musical manualmente.

Una de las cosas que me han agradado de este programa es que aparte de poder editar las etiquetas manualmentede en una interfaz bastante agradable y sencilla, también puedes obtener toda la información necesaria a través de Amazon Web Services, lo anterior incluye: Número, Título, Año, Estilo, Portada y demás información relacionada con las canciones. Al utilizar este servicio cuentas con una amplia bases de datos, lo anterior en realidad permite ahorrar mucho tiempo.

Dentro de las preferencias de este programa nos encontraremos con opciones que nos permitirán renombrar ficheros de acuerdo a un patrón, el cual lo podemos generar al combinar cualquiera de las siguientes palabras claves.

- Artist

- Album

- Title

- Track

- Genre

- Year

Las palabras claves anteriores se explican por sí solas. Simplemente escoge el patrón que más se ajuste a tus necesidades. Entre otras de las características de este programa, cabe mencionar la posibilidad de generar un fichero de lista de reproducción del álbum.

¿Tienes una larga colección de música cuyas etiquetas debes arreglar?, no te preocupes, Cowbell también puedes usar desde la línea de comandos, la manera de invocar el comando es la siguiente:

$ cowbell --batch /ruta/a/tu/musica

Donde evidentemente debes modificar el directorio /ruta/a/tu/musica de acuerdo a tus necesidades.

Para instalar esta aplicación en ubuntu debes tener activo el repositorio universe en tu fichero /etc/apt/sources.list. Una vez actualizada la lista de repositorios, puedes instalar Cowbell de la siguiente manera:

$ sudo aptitude cowbell

Integridad del CD de Ubuntu

Recientemente un amigo (de ahora en adelante lo llamaré pepito) al que le regalé un par de CD’s de Ubuntu, me preguntó después de unos días lo siguiente: Milton, ¿cómo puedo verificar la integridad del CD de instalación de Ubuntu?.

En primer lugar, estaba muy contento porque pepito deseaba en realidad migrar a GNU/Linux. Pero la idea de este artículo no es hablarles de pepito, sino describir lo más detalladamente posible la respuesta que le dí.

Aprovechar las opciones que nos brinda el CD de instalación

El mismo CD de instalación de ubuntu nos brinda una opción que nos permite verificar la integridad del disco, para ello debemos realizar lo siguiente:

- Colocar el CD de instalación de Ubuntu en la unidad de CD-ROM correspondiente, seguidamente proceder a reiniciar, recuerde que en la configuración de la BIOS debe tener como primera opción de arranque la unidad de CD-ROM que corresponda en su caso.

- Al terminar la carga del CD usted podrá apreciar un mensaje de bienvenida similar al siguiente:

The default installation is suitable for most desktop or laptops systems. Press F1 for help and advanced installation options.

To install only the base system, type “server” then ENTER. For the default installation, press ENTER.

boot:_

Lo anterior, traducido a nuestro idioma sería similar a:

La instalación por defecto es conveniente para la mayoría de los sistemas de escritorio o portátiles. Presione F1 para ayuda y opciones de instalación avanzadas.

Para instalar solo el sistema base, escriba “server” luego ENTER. Para la instalación por defecto, presione ENTER.

- Para este artículo, se realizará el modo de instalación por defecto, lo anterior quiere decir que solamente debemos presionar la tecla ENTER, enseguida observaremos la carga del kernel.

- Desde el cuadro de dialogo Choose Language, primero en aparecer, presionaremos la tecla Tab y seguidamente debemos seleccionar la opción Go back

- El paso anterior nos llevará al menú principal de la instalación de Ubuntu (Ubuntu installer main menu), una vez ubicados acá, simplemente debemos seleccionar la opción Check the CD-ROM(s) Integrity.

- Al finalizar el paso anterior nos llevará a un cuadro de dialogo de confirmación, pero antes podremos notar una pequeña advertencia:

Warning: this check depends on your hardware and may take some time.

Check CD-ROM integrity?

Lo anterior, traducido a nuestro idioma sería similar a:

Advertencia: Esta revisión depende de su hardware y puede tomar cierto tiempo.

Revisar la integridad del CD-ROM?

A la pregunta anterior respondemos Sí

- Si lo prefiere, salga de su casa, tome un poco de sol y regrese ;)

- Si el CD-ROM no tiene fallo alguno, podrá observar un mensaje al final de la revisión similar al siguiente:

Integrity test successful the CD-ROM. Integrity test was successful.

The CD-ROM is valid

Si la revisión de la integridad del CD-ROM es satisfactoría, puede continuar con el proceso de instalación.

Suerte y bienvenido al mundo GNU/Linux ;)

Ubuntu (Dapper Drake) Flight 3

La tercera versión alpha de Ubuntu 6.04 (Dapper Drake), continúa mostrando mejoras e incluye nuevo software.

Las mejoras incluyen una actualización en el tema, el cual desde la segunda versión alpha es manejado por gfxboot.

Ademas se incluye X Window System versión X11R7, GNOME 2.13.4, también se observan mejoras y simplificación de los menús, algunas nuevas aplicaciones como XChat-GNOME, un LiveCD más rápido y que permite almacenar nuestras configuraciones.

También se notan algunas mejoras estéticas en el cuadro de dialógo de cierre de sesión.

En cuanto a la mejora y simplificación de los menús, la idea básicamente es obviar aquellas opciones que pueden llegar a ser confusas para los usuarios, también se evita la duplicación de opciones, esto permite que exista un solo punto para acceder a cada función del sistema, mejorando de esta manera la usabilidad en nuestro escritorio favorito.

Se ha creado un nuevo dialógo que indica cuando es necesario reiniciar el sistema, esto sucede cuando se realizan importantes actualizaciones al sistema, en donde es recomendable reiniciar el sistema para que dichas actualizaciones surtan efecto.

¿Qué mejoras incluye la versión LiveCD?

Quién haya usado alguna vez en su vida un LiveCD puede haberse percatado que éstos presentan ciertos problemas, uno de ellos es la lentitud en el tiempo de carga del sistema, en este sentido se han realizado algunas mejoras en el cargador utilizado en el arranque, el tiempo de carga se ha reducido aproximadamente de unos 368 segundos a 231 segundos, esta mejora es bastante buena, aunque se espera mejorar aún mas este tiempo de carga del LiveCD.

Otro de los problemas encontrados en los LiveCD, es que el manejo de los datos no es persistente, esta nueva versión incluye una mejora que permite recordar las configuraciones, esto quiere decir que la siguiente vez que usted utilice el LiveCD dichas configuraciones serán recordadas. Esto es posible ya que el LiveCD permite guardar sus cambios en un dispositivo externo (al CD) como por ejemplo un llavero usb. Por lo tanto, si usted especifica el parámetro persistent cuando usted esta iniciando el LiveCD, éste buscará el dispositivo externo que mantiene las configuraciones que usted ha almacenado. Si desea conocer más acerca de esta nueva funcionalidad en el LiveCD vea el documento LiveCDPersistence.

Si usted desea descargar esta tercera versión alpha de Ubuntu 6.04, puede hacerlo en Ubuntu (Dapper Drake) Flight CD 3.

Mayor detalle acerca de las nuevas características que presenta esta nueva versión en el documento DapperFlight3.

Nota: Esta versión no es recomendable instalarla en entornos de producción, la versión estable de Dapper Drake se espera para Abril de este mismo año.

Gnickr: Gnome + Flickr

Gnickr le permite manejar las fotos de su cuenta del sitio Flickr como si fueran archivos locales de su escritorio Gnome. Todo lo anterior lo hace creando un sistema de ficheros virtual de su cuenta en Flickr.

Hasta ahora, Gnickr le permite realizar las siguientes operaciones:

- Subir fotos.

- Renombrar fotos y set de fotos.

- Borrar fotos.

- Insertar fotos en sets previamente creados.

- Eficiente subida de fotos, escala las imágenes a

1024 x 768

Se planea que en futuras versiones se pueda editar la descripción de cada foto, la creación/eliminación de sets de fotos, establecer las opciones de privacidad en cada una de las fotos, así como también integrar el proceso de autorización en nautilus.

Si desea instalar Gnickr, previamente debe cumplir con los siguientes requisitos.

- Gnome 2.12

- Python 2.4

- gnome-python >= 2.12.3

- Librería de imágenes de Python (PIL)

Instalando Gnickr en Ubuntu Breezy

En primer lugar debemos actualizar el paquete gnome-python (en ubuntu recibe el nombre de python2.4-gnome2) como mínimo a la versión 2.12.3, para ello descargamos el paquete python2.4-gnome2_2.12.1-0ubuntu2_i386.deb.

Seguidamente descargamos el paquete Gnickr-0.0.3 para Ubuntu Breezy. Una vez descargados los paquetes procedemos a instalar cada uno de ellos, para ello hacemos.

$ sudo dpkg -i python2.4-gnome2_2.12.1-0ubuntu2_i386.deb

$ sudo dpkg -i gnickr_0.0.3-1_i386.deb

Una vez que hemos instalado el paquete Gnickr para Ubuntu Breezy debemos autorizarlo en nuestra cuenta Flickr para que éste programa pueda manipular las fotos, para ello hacemos lo siguiente.

$ gnickr-auth.py

Simplemente debe seguiremos las instrucciones que nos indica el cuadro de dialogo. Una vez completado el proceso de autorización debe reiniciar nautilus.

$ pkill nautilus

Uso de Gnickr

El manejo de Gnickr es muy sencillo, para acceder a sus fotos en su cuenta Flickr simplemente apunte nautilus a flickr:///.

$ nautilus flickr:///

También puede ver las fotos de cualquier otra cuenta en Flickr apuntando a flickr://[nombreusuario].

Para agregar fotos a un set, simplemente arrastre desde la carpeta Unsorted hasta la carpeta que representa el set de fotos que usted desea, lo anterior también puede aplicarse para mover una foto de un set a otro.

Para renombrar una foto, simplemente modifique el nombre del fichero de la foto.

Vulnerabilidad en Apache

Según un anuncio hecho el día de hoy por Adam Conrad a la lista de seguridad de ubuntu existe una vulnerabilidad que podría permitirle a una página web maligna (o un correo electrónico maligno en HTML) utilizar técnicas de Cross Site Scripting en Apache. Esta vulnerabilidad afecta a las versiones: Ubuntu 4.10 (Warty Warthog), Ubuntu 5.04 (Hoary Hedgehog) y Ubuntu 5.10 (Breezy Badger).

De manera adicional, Hartmut Keil descubre una vulnerabilidad en el módulo SSL (mod_ssl), que permitiría realizar una denegación de servicio (DoS), lo cual pone en riesgo la integridad del servidor. Esta última vulnerabilidad solo afecta a apache2, siempre y cuando esté usando la implementación “worker” (apache2-mpm-worker).

Los paquetes afectados son los siguientes:

apache-commonapache2-commonapache2-mpm-worker

Los problemas mencionados previamente pueden ser corregidos al actualizar los paquetes mencionados.

Vulnerabilidad en Perl

Las siguientes versiones se encuentran afectadas ante este fallo de seguridad:

- Ubuntu 4.10 (Warty Warthog)

- Ubuntu 5.04 (Hoary Hedgehog)

- Ubuntu 5.10 (Breezy Badger)

En particular, los siguientes paquetes se encuentran afectados:

libperl5.8perl-base

El problema puede ser corregido actualizando los paquetes a sus últimas versiones en las respectivas versiones de Ubuntu. En general, el modo estándar de actualizar la distribución será mas que suficiente.

$ sudo aptitude dist-upgrade

La actualización pretende solucionar una vulnerabilidad del interprete Perl, el cual no era capaz de manejar todos los posibles casos de una entrada malformada que podría permitir la ejecución de código arbitrario, así que es recomendable actualizar su sistema de inmediato.

Sin embargo, es importante hacer notar que esta vulnerabilidad puede ser aprovechada en aquellos programas inseguros escritos en Perl que utilizan variables con valores definidos por el usuario en cadenas de caracteres y en donde no se realiza una verificación de dichos valores.

Si desea mayor detalle, le recomiendo leer el anuncio hecho por Martin Pitt en [USN-222-1] Perl vulnerability.

edubuntu es adaptable al ambiente familiar?

Es importante hacer notar que el objetivo primordial de edubuntu es ofrecer una alternativa para el ambiente escolar (puede ser igualmente usable por los niños en casa), ofreciendo dos modos de instalación (servidor y estación de trabajo), el primero de los modos de instalación es ideal para ambientes escolares donde existen laboratorios, se provee LTSP (Linux Terminal Server Project), el cual permite que otros ordenadores (los cuales fungen como clientes) se conecten al servidor y utilicen los recursos de éste para ejecutar sus aplicaciones de escritorio.

Lo anterior resulta muy interesante porque permite mantener todas las aplicaciones en un solo lugar (el servidor), cualquier actualización que se haga ocurrirá únicamente en éste. Por lo tanto, cada vez que un cliente inicie sesión, automáticamente estará ejecutando un sistema actualizado.

La aclaración anterior viene dada por el artículo Review: Is Edubuntu truly the operating system for families?, redactado por Jay Allen, en donde el autor hace una revisión de uno de los sabores de ubuntu, edubuntu, pensando que éste estaba orientado exclusivamente a los niños de la casa.

El autor intenta dar su punto de vista como un padre de familia con pocos conocimientos de informática y no como el desarrollador de software que ha sido por 12 años.

| Muchos de los lectores seguramente sabrán que los sabores orientados a los usuarios de casa son: Ubuntu, Kubuntu y quizás Xubuntu, pero no le podemos decir a un padre de familia que tiene pocos conocimientos en el área lo suguiente: Instala (X | K)ubuntu y seguidamente procede a instalar el paquete edubuntu-desktop. Esta opción quedará descartada en el siguiente artículo ya que desde el punto de un padre con pocos conocimientos en informática pero que esté preocupado por la educación de sus hijos preferirá tener el sistema que el realmente desea en un instante, en vez de tener que instalar ciertos paquetes para obtener lo que él en realidad necesita. |

Edubuntu brinda un sistema operativo lleno de paquetes educacionales, juegos, herramientas de publicación, edición gráfica y más. Todo lo descrito previamente de manera gratuita (sin cargo alguno y comprometido con los principios del Software Libre y el Código de Fuente Abierta), se realiza un gran trabajo para ofrecer una excelente infraestructura de accesibilidad, incluso para aquellos usuarios que no están acostumbrados al manejo de ordenadores, dentro de esa infraestructura de accesibilidad se considera el lenguaje, edubuntu brinda un sistema operativo que se adapta a cualquier usuario sin importar su lenguaje.

Edubuntu puede ser la respuesta a aquellas familias con pocos recursos económicos, en donde el tener acceso a un ordenador de altas prestaciones es un lujo, o en aquellos casos donde se tenga que pagar altas sumas de dinero anualmente por mantener un sistema operativo ineficiente y lleno de problemas.

Edubuntu le brindaría a estos niños (y familias) todo el poder y flexibilidad que ofrecen los sistemas *nix, todos estos beneficios a muy bajos costos.

He considerado importante esta revisión hecha por Jay Allen acerca de edubuntu, porque no es difícil imaginar que esos millones (espero) de niños que utilizan edubuntu en sus escuelas por horas, también quisieran tener ese sistema operativo tan agradable en sus casas.

Según la opinion del autor de la revisión, Jay Allen, después de experimentar con edubuntu por un día con sus hijos Neve, Jaxon, Veda de 8, 6 y 4 años respectivamente, afirma que edubuntu aún no está totalmente listo para aquellas familias con pocos conocimientos en el campo de la tecnología, pero con las características que ofrece hasta ahora es capaz de mantener satisfechos tanto a adultos como niños.

Puntos a favor para edubuntu

- Edubuntu es ideal para ordenadores de bajos recursos, por ejemplo, el autor de la revisión instaló edubuntu en una máquina con procesador Celeron a 550 MHz, 17 GB de disco duro, 4 GB en un disco duro secundario y con 192 MB de RAM.

- Respecto al punto anterior, edubuntu es capaz de brindar una mejor experiencia para los niños en un ordenador de bajos recursos que tenga instalado por ejemplo Windows 98.

- Una vez instalado edubuntu, éste ofrece una interfaz sencilla, usable y muy rápida.

- El sistema viene precargado con una serie de características muy amenas para los niños. De igual manera, se ofrecen características muy atractivas para los adultos de la casa, entre las que se encuentran, una suite ofimática realmente completa, herramientas para la manipulación de imágenes, visualización de películas y videos.

- Mozilla Firefox es incluido por defecto en la instalación, así que si está acostumbrado a él en otros ambientes, la transición no será traumática.

- Algunos de sus niños ni siquiera se dará cuenta del cambio, tal es el caso de Veda, el menor de los hijos de Jay Allen, ni siquiera se percató que su padre secretamente reemplazó Windows XP por edubuntu.

- Al pasar las semanas y sus hijos se hayan acostumbrado al sistema, puede mostrarle características más avanzadas de edubuntu sin mucha dificultad, es más, seguramente ellos ya las sepan, recuerde que los niños son muy curiosos.

Puntos en contra para edubuntu

- ¿Cuántos padres o madres en realidad entenderán lo que significan cada uno de los modos de instalación que ofrece edubuntu?, sobretodo si éstos optan por el modo de instalación por defecto, el cual es modo servidor (server), cuando en realidad deben elegir el modo de estación de trabajo (workstation).

- Muchos de los mensajes que muestra el asistente para la instalación contienen un lenguaje técnico, lo cual no es ideal en aquellos padres o madres con pocos o nulos conocimientos al respecto.

- El asistente de instalación ofrece la creación de una única cuenta, la cual puede en cualquier instante tener permisos administrativos a través del comando

sudo(acerca de ello explico un poco en el artículo ¿Es necesario activar la cuenta root en Ubuntu?), esto puede ser terrible en esos casos donde los padres o madres posean pocos o nulos conocimientos respecto a la creación de usuarios desde la cuenta predeterminada, permisos administrativos, entre otras cuestiones. Según la opinión de Jay Allen, preferiría alguna de las siguientes opciones, que el mismo asistente le dé la oportunidad de crear otra cuenta con permisos limitados o que pueda crear una cuenta para cada uno de sus hijos. - Otro punto en contra es el uso de nombre un tanto crípticos en la suite de educación KDE, incluso, la hija de Jay Allen, Neve (8 años de edad), se preguntaba en voz alta el por qué de la existencia del prefijo K en los nombres de las aplicaciones de la suite, para ella simplemente no tenía sentido. En este caso, lo más lógico sería colocar nombres más explicativos en las aplicaciones. Por lo tanto, no tendría que ser necesario abrir una aplicación solamente para saber de que trata o que soluciones puede brindarle.

- Otro punto en contra es el hecho que el programa Mozilla Firefox no traiga por defecto una sección que permita de cierta manera controlar la navegación de sus hijos, para evitar que estos últimos vean contenido explícito para adultos. Respecto a este punto en particular no es responsabilidad de edubuntu como tal, debido a que el nombre Firefox es una marca registrada (esto puede ser conveniente para el control de calidad de la aplicación como tal), a pesar que el proyecto de la Fundación Mozilla es código abierto, no se pueden realizar cambios a la aplicación original y distribuirla bajo el mismo nombre. Por lo tanto, los desarrolladores de edubuntu deben elegir entre dejar de usar el reconocido nombre Firefox, o no incluir ninguna extensión útil. Más adelante se darán detalles acerca de como solucionar este problema.

Propuestas

De la revisón hecha por Jay Allen, han salido algunas propuestas, entre ellas, una de las que me llamó la atención fué la de distribuir de manera separada los dos modos de instalación de edubuntu, lo anterior sería ideal en esos casos (que deben ser cientos) donde el padre (o madre) no posea muchos conocimientos acerca del tema, éste no sabrá que opción elegir, cuando él (o ella) ni siquiera sabe lo que significa instalación en modo servidor o modo estación de trabajo. También podría considerarse cambiar el modo de instalación por defecto, en vez de ser servidor, cambiarlo por estación de trabajo.

Otra propuesta interesante es la necesidad de proporcionar tutoriales interactivos que de alguna manera introduzcan a los niños de diversas edades en las características, capacidades y beneficios que les proporciona el sistema que manejan.

Si edubuntu no quiere prescindir del conocido nombre Firefox, debe facilitar después de la instalación una guía que indique los pasos necesarios para establecer el control de la navegación de los niños. Sería ideal colocar una guía para instalar dicha extensión o plugin en la página inicial de Firefox, o proporcionar un acceso directo a esta guía de “Primeros Pasos” desde el escritorio de la cuenta predeterminada.

Clientes BitTorrent

Desde mi punto de vista Azureus es un cliente BitTorrent que cae en los excesos, aparte de ello es demasiado lento y por si fuera poco consume una gran cantidad de recursos del sistema.

Si usted es usuario de Ubuntu Linux, seguramente estará preguntándose, ¿por qué buscar un cliente BitTorrent si Breezy incluye uno? , bueno, si le soy sincero, ese cliente apesta, tiene muy pocas opciones.

En los siguientes párrafos veremos dos alternativas, que desde mi punto de vista tienen ciertas virtudes, las cuales muestro a continuación.

- No caen en los excesos.

- Son rápidos.

- No consumen gran cantidad de recursos del sistema.

- Ofrecen muchas opciones.

Sin mas preámbulos, les presento a Rufus y freeloader, clientes BitTorrents alternativos de gran envergadura.

FreeLoader

Freeloader, es un manejador de descargas escrito en Python y brinda soporte a torrents.

Para instalar freeloader debemos seguir los siguientes pasos en Breezy.

sudo aptitude install python-gnome2-extras python2.4-gamin

Seguidamente diríjase al sitio oficial de freeloader y descargue las fuentes del programa, para la fecha en la cual se redactó este artículo la versión más reciente de este programa es la 0.3.

wget http://www.ruinedsoft.com/freeloader/freeloader-0.3.tar.bz2

Luego de haber descargado el paquete proceda de la siguiente manera:

$ tar xvjf freeloader-0.3.tar.bz2

$ cd freeloader-0.3

$ ./configure

$ make

$ sudo make install

Recuerde que para poder compilar paquetes desde las fuentes necesita tener instalado previamente el paquete build-essential

Rufus

Rufus es otro cliente BitTorrent escrito en Python.

Vamos a aprovecharnos del hecho que existe una versión estable (0.6.9) compilada * para Breezy, los pasos son los siguientes:

$ wget http://strikeforce.dyndns.org/files/breezy/rufus.0.6.9/rufus_0.6.9-0ubuntu1_i386.deb

$ sudo dpkg -i rufus_0.6.9-0ubuntu1_i386.deb

- Esta versión ha sido compilada por strikeforce, para mayor información lea el hilo Rufus .deb Package.

Videos educacionales de ubuntu

Chris Del Checcolo y Ricky Hussmann, estudiantes miembros de la ACM en la WVU, han hecho públicos un par de videos educacionales (algo graciosos, no puedo negarlo) en los que explican como instalar software en Ubuntu Linux, ya sea haciendo uso del Gestor de paquetes Synaptic o desde las fuentes. De manera adicional explican como puede convivir Ubuntu Linux con un sistema Windows previamente instalado haciendo uso de Dual Boot.

- Ubuntu Linux / Windows Dual Boot Instructional Video (inglés).

- Installing Software on Ubuntu Linux (inglés).

Vía: The Fridge.

Reproducir de manera automática los CDs o DVDs con XMMS y VLC

Si desea reproducir automáticamente los CDs de audio (o DVDs) al ser insertados con XMMS (o con VLC) simplemente cumpla los siguientes pasos:

En primer lugar diríjase a Sistema -> Preferencias -> Unidades y soportes extraíbles, desde la lengüeta Multimedia proceda de la siguiente manera:

Si desea reproducir automáticamente un CD de sonido al insertarlo:

- Marque la casilla de verificación Reproducir CD de sonido al insertarlo

- En la sección de comando escriba lo siguiente:

xmms -p /media/cdrom0

Si desea reproducir automáticamente un DVD de vídeo al insertarlo

- Marque la casilla de verificación Reproducir DVD de vídeo al insertarlo

- En la sección de comando escriba lo siguiente:

wxvlc dvd:///dev/dvd

Nota: En XMMS puede ser necesario configurar el plugin de entrada de audio que se refiere al Reproductor de CD de audio (libcdaudio.so), puede configurarlo desde las preferencias del programa.

Cómo cambiar entre versiones de JAVA bajo Breezy

Si usted tiene instaladas múltiples versiones de JAVA bajo Breezy, puede cambiar fácilmente entre dichas versiones cuando usted lo desee.

Simplemente debe hacer uso del comando update-alternatives --config java y luego podrá escoger su versión de java preferida.

$ sudo update-alternatives --config java

There are 3 alternatives which provide `java'.

Selection Alternative

-----------------------------------------------

1 /usr/bin/gij-wrapper-4.0

+ 2 /usr/lib/jvm/java-gcj/bin/java

* 3 /usr/lib/j2re1.5-sun/bin/java

Press enter to keep the default[*], or type selection number:

Si usted es amante de las soluciones gráficas, no se preocupe, existe una alternativa, con galternatives podrá elegir qué programa le prestará un servicio en particular, para instalar galternatives debe teclear el siguiente comando:

$ sudo aptitude install galternatives

Para ejecutarlo debe hacer lo siguiente:

$ sudo galternatives

Su interfaz de uso es muy sencilla, si desea cambiar la versión de JAVA que desea utilizar simplemente escoga java en la sección de alternativas, seguidamente seleccione la versión que más crea conveniente en la sección de opciones

Restaurando la vieja barra de localización en nautilus

Si usted al igual que yo no le gusta la nueva manera en que se presenta la barra de localización en nautilus bajo Breezy, en donde se emplean las barras de rutas, es posible regresar a la vieja configuración (tal cual como en Hoary) en donde se especificaba de manera textual la ruta actual en la barra de localización.